Robert Spekkens et Kevin Resch se connaissent depuis la période de leurs études supérieures il y a quelque 25 ans, alors que M. Spekkens étudiait la physique théorique et que M. Resch devenait un expérimentateur. Mais leurs domaines d’expertise distincts ne les ont pas empêchés de travailler en collaboration. Cette combinaison en fait même une équipe extrêmement productive.

Robert Spekkens est physicien théoricien à l’Institut Périmètre. Il se spécialise dans les fondements quantiques, discipline qui cherche à approfondir et à reformuler la physique quantique, afin de mieux en comprendre le fonctionnement interne et de clarifier ses caractéristiques contre-intuitives.

Pour sa part, Kevin Resch est un expert de l’optique quantique. Dans son laboratoire de l’Institut d’informatique quantique ainsi qu’au Département de physique et d’astronomie de l’Université de Waterloo, il conçoit et effectue des expériences sur des photons intriqués. Avec un groupe d’étudiants diplômés et postdoctorants talentueux, il pose de nouvelles questions fondamentales pour trouver des innovations conceptuelles en physique quantique et examiner comment elles diffèrent des théories classiques qui les ont précédées.

« Il y a une collaboration naturelle entre ceux qui font le genre d’expériences d’optique quantique effectuées dans le laboratoire de Kevin et les gens comme moi, qui veulent mettre à l’épreuve la frontière entre la physique quantique et la physique classique », explique M. Spekkens à propos des origines de leur partenariat en 2014. « Dans la région, Kevin est la personne toute indiquée pour mettre en œuvre ce genre de tests. »

Lorsqu’ils se sont rendu compte de la complémentarité de leurs objectifs de recherche, MM. Spekkens et Resch se sont rapidement mis à collaborer, et ils ont jusqu’à maintenant écrit 7 articles ensemble. Chacun de ces articles combine une idée théorique et un test expérimental, et dans chacun d’eux les chercheurs tentent de démêler un nœud différent aux limites vagues de la physique quantique.

Leur plus récent projet : sauver la causalité en physique quantique

Leur résultat le plus récent — obtenu avec l’étudiant diplômé Patrick Daley — est une nouvelle version d’une expérience qui joue un rôle central dans les fondements de la physique quantique : une « expérience de Bell ».

Ce genre d’expérience porte le nom du physicien irlandais John Bell, qui s’intéressait à deux particules préparées ensemble initialement, puis envoyées loin l’une de l’autre pour faire l’objet de diverses mesures.

En 1964, Bell a démontré, dans le théorème qui porte maintenant son nom, que certains types de corrélations entre les résultats des mesures ne peuvent pas s’expliquer par l’existence d’une cause commune (autrement dit, il semble n’y avoir aucune sorte d’information partagée qui détermine l’état des deux particules avant leur séparation) — du moins selon la théorie classique des probabilités.

Pourtant, la physique quantique prédit, et des tests expérimentaux confirment, que de telles corrélations se produisent dans le montage de Bell. Cela a conduit certains chercheurs à prétendre qu’il est inapproprié de rechercher une explication causale de ces corrélations. D’autres scientifiques, par contre, ne veulent faire aucun compromis quant aux explications causales et cherchent donc des moyens de contourner l’absence d’explication de Bell.

Le caractère étrange de la physique quantique ressemble à une bosse dans un tapis. Si on élimine la bosse à un endroit, elle se déplace à un autre endroit. Les différentes idées sur la manière de fournir une explication causale des corrélations quantiques dans une expérience de Bell sont comme différents endroits où la bosse apparaît dans le tapis.

Certains soumettent que c’est l’hypothèse de Bell sur la structure causale de l’expérience qui doit être abandonnée. Ils imaginent, par exemple, que le lien entre les deux volets de l’expérience pourrait ne pas être un lien de cause commune, mais plutôt un lien de cause à effet, de sorte que le choix d’une mesure d’un côté influence le résultat de l’autre mesure. Pour cela, il faudrait que cette influence s’exerce à une vitesse supérieure à celle de la lumière — une sorte d’« effrayante action à distance », comme le disait Einstein.

Une autre idée de cette catégorie est appelée superdéterminisme : on présume que les variables qui exercent une influence causale sur le résultat des mesures exercent aussi une influence causale sur le choix des mesures à effectuer, et non que ces mesures puissent être choisies librement. Cela constitue une autre manière de rejeter l’hypothèse de Bell sur la structure causale.

D’autres encore soumettent que la structure de cause commune est correcte — qu’il n’y a donc aucune action effrayante à distance —, mais qu’il faut remplacer la théorie classique des probabilités par une théorie plus exotique permettant de faire des inférences en présence d’une information incomplète, ce qui a des répercussions sur les types de corrélations pouvant résulter d’une cause commune. Ces théories exotiques des probabilités sont des modèles de cause commune quantique.

Les démarches de la première catégorie sont conservatrices pour ce qui est des concepts de causalité et d’inférence, mais radicales à propos de la structure causale. Les démarches de la seconde catégorie sont conservatrices pour ce qui est de la structure causale (il s’agit bien d’une cause commune), mais radicales à propos des concepts de causalité et d’inférence.

MM. Spekkens, Resch et Daley souhaitaient trouver une version d’une expérience de Bell et une manière d’analyser les données, qui pourraient permettre de trancher entre ces deux catégories de démarches. Ils ont eu recours à une paire de photons (particules de lumière) intriqués. Les photons constituent un outil idéal pour ce genre d’expérience, car ils ne subissent pas beaucoup d’interactions, ce qui leur donne une longue durée de cohérence : autrement dit, les photons restent dans un état intriqué pendant un temps relativement long, sans être perturbés par des interactions avec le monde qui les entoure.

Le passage d’une lumière laser à travers un matériau optique non linéaire précis appelé ppKTP (phosphate de titanyle et de potassium périodiquement polarisé) produit des paires de photons intriqués. On transmet ensuite chaque photon d’une paire dans un câble à fibre optique, puis on mesure sa polarisation d’une manière choisie parmi plusieurs possibles. Si l’on produit un très grand nombre de paires pour différentes manières de mesurer la polarisation, et que l’on consigne les fréquences relatives des résultats de ces mesures de polarisation, une telle expérience permet de caractériser des aspects des corrélations quantiques.

Analyse des données expérimentales : Un modèle correspond aux données, mais se peut-il qu’il leur corresponde trop bien?

La partie la plus originale du travail des chercheurs a résidé dans l’analyse des données.

La difficulté venait du fait que les deux types de modèles — d’une part, les modèles causaux classiques permettant une « effrayante action à distance » ou les modèles de superdéterminisme, et d’autre part les modèles de cause commune quantique — peuvent correspondre aux données produites par l’expérience. Comment peut-on alors déterminer quel type de modèle est le bon?

« Il y a encore un moyen, dit M. Spekkens. Il consiste à vérifier non seulement si ces modèles peuvent correspondre aux données — peuvent-ils rendre probables les données que vous avez observées? —, mais aussi s’ils sont surajustés, ou correspondent trop bien, aux données.

« Un modèle surajusté aux données passe à côté des fluctuations statistiques qui surviennent dans la réalité. Si l’on donne à un modèle trop de degrés de liberté, par exemple trop de paramètres, ces degrés de liberté supplémentaires peuvent produire une correspondance qui n’est plus aussi bonne avec des données nouvelles pour le modèle. »

Et M. Resch d’ajouter : « Ces modèles tiennent parce qu’ils correspondent à toutes les petites caractéristiques aléatoires des données, caractéristiques qui ne se répéteront probablement pas. »

Pour vérifier si certains modèles étaient surajustés aux données, l’équipe a d’abord soumis des données au cours d’une phase d’apprentissage. Puis, dans un second temps, elle a soumis de nouvelles données, afin de voir si les modèles pouvaient encore prédire avec exactitude les résultats de l’expérience.

« Nous avons essentiellement constaté que les modèles permettant une causalité supraluminique [effrayante action à distance] ou un superdéterminisme avaient tendance à être surajustés aux données, dit M. Spekkens. Au bout du compte, ils ont de moins bonnes performances avec les données de test. » Les modèles de cause commune quantique évitaient beaucoup mieux le surajustement.

Que signifient ces résultats? Premièrement, ils renforcent l’idée selon laquelle nous ne comprenons pas complètement le monde quantique. Les expériences de Bell ne vont pas dans le sens d’une effrayante action à distance ou de corrélations superdéterministes, mais elles nous enseignent que nous devons trouver un nouveau type d’explication causale, où les notions de causalité et d’inférence sont différentes de celles des théories classiques.

Nous n’avons pas encore de verdict final, mais les résultats vont dans le sens d’une idée issue de travaux théoriques récents dans le domaine de l’inférence causale quantique : « La structure causale est bonne, il s’agit encore d’une cause commune, dit M. Spekkens. Ce qui change, c’est la manière de définir un modèle de causalité, les paramètres, ainsi que la manière de calculer les corrélations. La démarche est donc radicale en ce qui concerne les paramètres, mais conservatrice pour ce qui est de la structure causale. »

Les conséquences de cela sont passionnantes, car elles pourraient permettre de sortir de l’une des impasses les plus persistantes de la physique moderne.

Harmoniser la théorie et l’expérimentation

Les résultats convaincants de cette expérience n’auraient pas pu être obtenus sans le long processus de collaboration mis en œuvre par MM. Resch et Spekkens. De fait, l’idée même de tester le surajustement est née de leurs travaux antérieurs.

« Certains thèmes persistent dans tous nos projets, dit M. Spekkens. Nous avons parlé ici de surajustement, qui a été un élément crucial de ce projet. Mais si vous nous demandez d’où est venue cette idée, nous vous répondrons qu’il en était déjà question lors de notre projet précédent. Elle résultait naturellement de notre expérience précédente. Ce genre de longue collaboration, avec les nouveaux outils et les manières de penser qu’elle suscite, fait en sorte que les prochaines questions surgissent naturellement. »

On dit souvent que la méthode scientifique consiste en un cycle itératif où les théoriciens inventent un modèle, les expérimentateurs le mettent à l’épreuve, et les résultats de l’expérience alimentent la prochaine théorie.

« La science n’évolue pas toujours de manière aussi nette, dit M. Resch. Les systèmes réels sont plus confus que cela, et plus intéressants. Je crois que les discussions les plus productives que nous avons eues, et peut-être même les résultats les meilleurs que nous avons obtenus, ont résulté de notre réflexion sur les manières de vaincre une partie de cette confusion. »

À titre d’exemple, les modèles des théoriciens comportent souvent des hypothèses idéalisées à propos d’un scénario. Par contre, dans la réalité, les expériences comportent du bruit, des imperfections et des erreurs aléatoires. MM. Resch et Spekkens ont constaté que cette réalité les a amenés à mieux faire de la science : ils ont dû apprendre à élaborer une théorie solide et, sur le plan expérimental, à trouver de nouvelles manières d’obtenir une caractérisation plus précise de leurs dispositifs en utilisant des techniques d’analyse innovatrices.

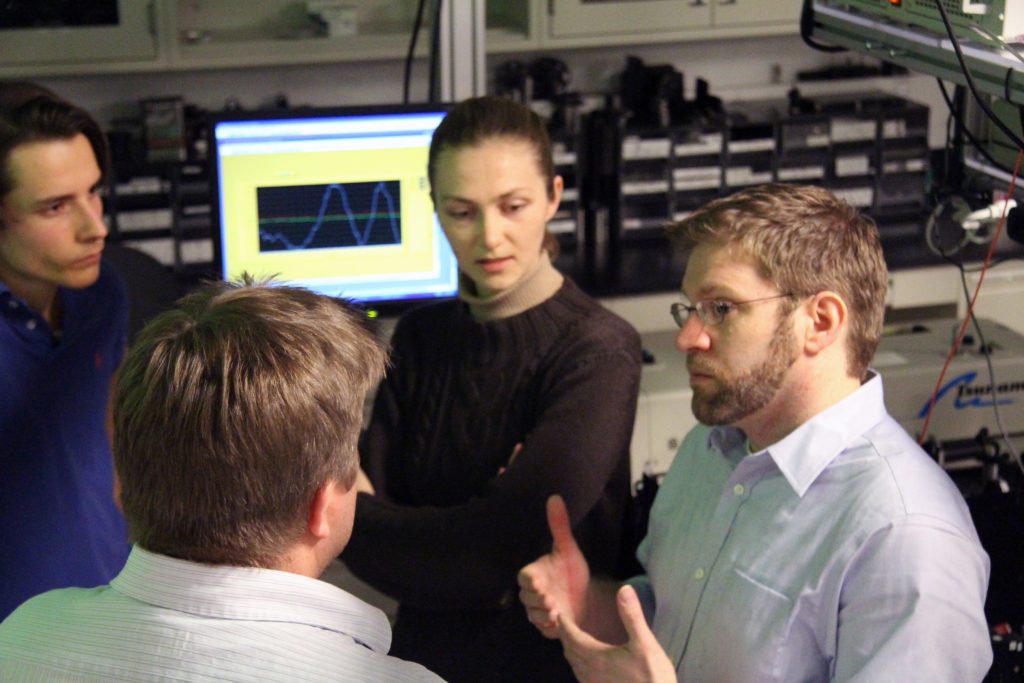

De gauche à droite : Jean-Philippe MacLean, Kevin Resch, Katja Ried et Robert Spekkens.

Source : Institut d’informatique quantique, Université de Waterloo[/caption]

Le dialogue constant entre les aspects théorique et expérimental de leurs projets a joué un rôle crucial dans leurs succès.

« Notre collaboration, dit M. Spekkens, se distingue par le fait que nos articles ont tendance à avoir à la fois un volet théorique et un volet expérimental. »

M. Resch abonde dans le même sens : « Dans certains cas, cela a été essentiel, car il y a beaucoup d’allers-retours entre les deux. Une théorie pourrait reposer sur des hypothèses impossibles à réaliser dans une expérience […] Il est donc important de pouvoir penser à une mise en œuvre concrète et de s’assurer que la théorie puisse en tenir compte. »

Les étudiants qui travaillent avec MM. Resch et Spekkens bénéficient eux aussi de cette collaboration unique en son genre. Les étudiants de Kevin Resch peuvent échanger avec des théoriciens et aborder certaines idées théoriques maîtresses, tandis que ceux de Robert Spekkens acquièrent une expérience précieuse en travaillant avec des expérimentateurs.

C’est un effort conjoint, interactif et non en silo. « Au lieu de rencontres sur la théorie limitées aux postdoctorants de l’Institut Périmètre, dit M. Spekkens, nous réunissons tout le monde pour discuter de l’aspect théorique d’un problème ouvert. C’est la même chose à propos de la conception d’une expérience ou pour parler de problèmes d’expérimentation qui ont pu surgir. C’est notre façon de fonctionner. Réunir tout le monde pour discuter de n’importe quelle difficulté à laquelle nous faisons face. »

En procédant de cette manière, les théoriciens aussi bien que les expérimentateurs comprennent mieux les défis à relever sous les deux aspects, ce qui en fait de meilleurs physiciens.

Applications et prochaines étapes : Ce n’est pas terminé

MM. Spekkens et Resch planifient leurs prochains travaux conjoints. Effectuées avec un nombre minimal de paramètres, les recherches décrites ici constituaient un point de départ, mais les chercheurs veulent aller plus loin.

« Dans ces modèles, le nombre de paramètres peut croître rapidement avec le nombre d’états et de mesures, dit M. Resch, et nous augmentons maintenant la complexité avec une meilleure expérience et un algorithme mieux adapté permettant une optimisation avec tous ces paramètres. »

Ces travaux nous donnent une compréhension plus approfondie de la causalité en mécanique quantique, mais ils peuvent aussi avoir des répercussions technologiques directes.

« Lorsque les inégalités de Bell ont été découvertes dans les années 1960, on ne leur trouvait à l’époque qu’un intérêt purement théorique, sans aucune application, dit M. Resch. Mais maintenant, avec l’émergence de technologies de l’information quantique, ces aspects très fondamentaux des systèmes quantiques ont des applications pratiques. Par exemple, les inégalités de Bell jouent maintenant un rôle dans la sécurité des communications. Si un système de communication quantique viole les inégalités de Bell, on peut être certain qu’aucun intrus ne pourra s’introduire dans le système.

« De la même manière, poursuit M. Resch, on a établi un lien entre la contextualité [caractéristique des systèmes quantiques selon laquelle les résultats de mesures ne peuvent être interprétés comme issus d’un ensemble de propriétés préexistantes] et l’amélioration quantique de la puissance de calcul. On peut considérer que nos recherches identifient de nouvelles ressources quantiques, ce qui peut mener à des applications auxquelles nous n’avons pas pensé jusqu’à maintenant. »

Une fois que ces ressources quantiques sont identifiées, on peut les exploiter pour des outils technologiques tels que des ordinateurs quantiques ou des dispositifs de communication et de cryptographie.

À long terme, la collaboration semble être le moteur de l’innovation. La théorie et l’expérimentation ont chacune quelque chose d’important à offrir, mais ensemble elles se renforcent mutuellement.

Comme le fait remarquer M. Resch, on ne peut trop insister sur « l’importance d’avoir autant de théoriciens et expérimentateurs talentueux réunis, comme c’est le cas à Waterloo, parce qu’ils peuvent réaliser beaucoup plus de choses ensemble que séparément. L’écosystème de la Quantum Valley est plus grand que la somme de ses parties […] La présente collaboration est un bon exemple de la manière dont cela fonctionne. »

Ressources supplémentaires

Les recherches décrites ci-dessus ont fait l’objet d’une publication dans Physical Review A au printemps dernier.

Le groupe de recherche de Kevin Resch sur l’optique quantique à l’Institut d’informatique quantique a un site Web qui permet de se renseigner sur ses activités.

L’Initiative sur l'inférence causale quantique de Robert Spekkens à l’Institut Périmètre a également une page Web donnant des renseignements sur les travaux de ce groupe.

Robert Spekkens et Kevin Resch ne font pas leurs recherches seuls, et il est important de reconnaître la contribution des étudiants diplômés et des postdoctorants qui ont participé à ces travaux au cours des années. En plus de Patrick J. Daley mentionné plus haut, il s’agit de Megan Agnew, Andrew Cameron, Michael Grabowecky, Ravi Kunjwal, Jean-Philippe W. MacLean, Michael D. Mazurek, Christopher Pollack, Matthew F. Pusey, Katja Ried et Lydia Vermeyden.

À propos de l’IP

L'Institut Périmètre est le plus grand centre de recherche en physique théorique au monde. Fondé en 1999, cet institut indépendant vise à favoriser les percées dans la compréhension fondamentale de notre univers, des plus infimes particules au cosmos tout entier. Les recherches effectuées à l’Institut Périmètre reposent sur l'idée que la science fondamentale fait progresser le savoir humain et catalyse l'innovation, et que la physique théorique d'aujourd'hui est la technologie de demain. Situé dans la région de Waterloo, cet établissement sans but lucratif met de l'avant un partenariat public-privé unique en son genre avec entre autres les gouvernements de l'Ontario et du Canada. Il facilite la recherche de pointe, forme la prochaine génération de pionniers de la science et communique le pouvoir de la physique grâce à des programmes primés d'éducation et de vulgarisation.

Ceci pourrait vous intéresser

Marina Maciel Ansanelli explore la réalité sous-jacente à la théorie quantique

janvier 29, 2025